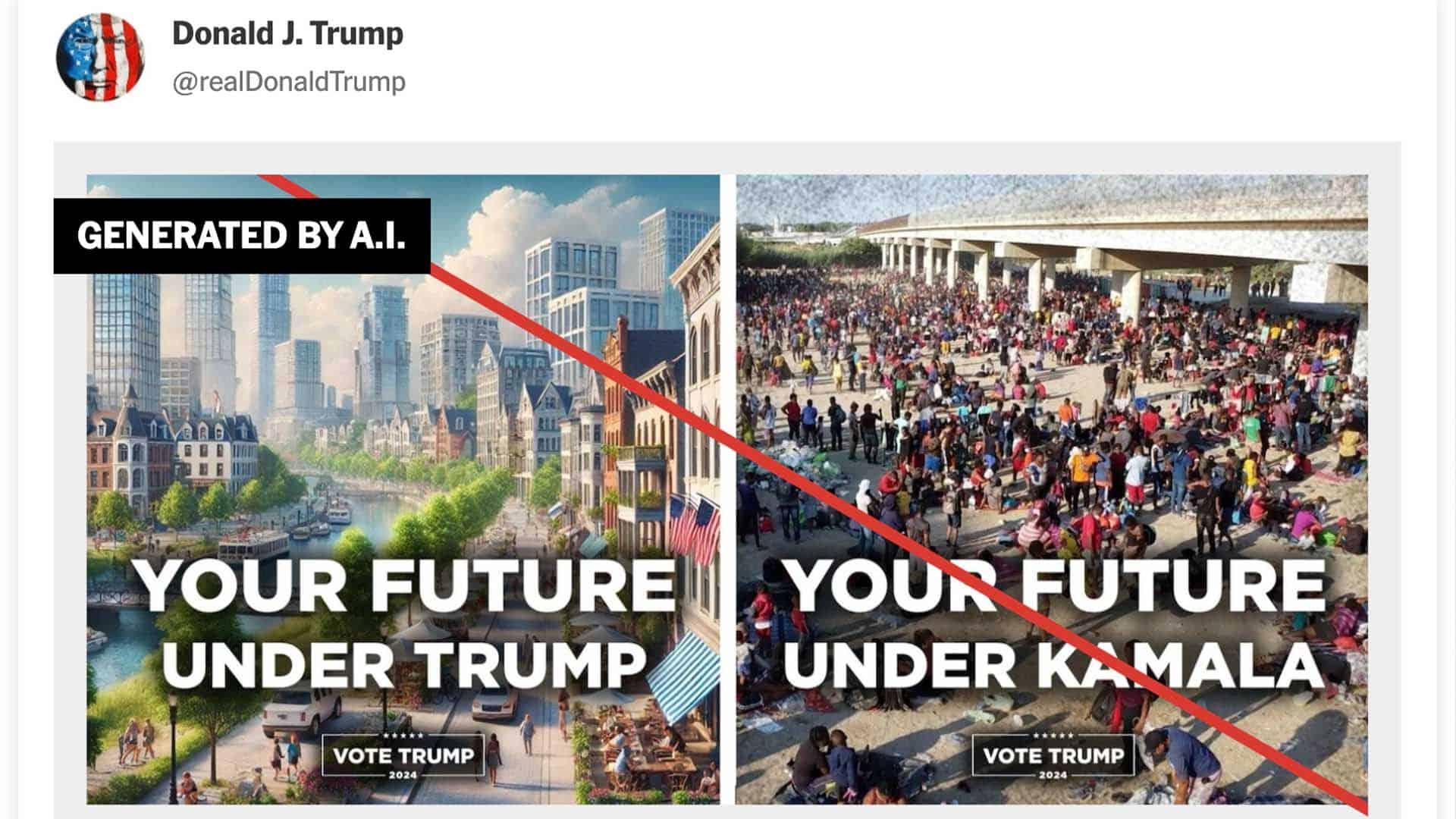

Індекс безпеки ШІ: навіть лідери галузі ледь витягують на “трійку”

Провідні компанії зі штучного інтелекту отримали тривожно низькі оцінки безпеки своїх систем, згідно з новим звітом Future of Life Institute. Навіть найкращі гравці ринку – Anthropic, OpenAI та Google DeepMind – отримали лише оцінку С+ або С, що приблизно відповідає “трійці”.

Індекс безпеки ШІ Future of Life Institute за літо 2025 року виявив, що галузь принципово не готова до власних заявлених цілей. Компанії стверджують, що досягнуть штучного загального інтелекту (AGI) протягом десятиліття, проте жодна не отримала вище D у плануванні екзистенційної безпеки. Один з рецензентів назвав цей розрив “глибоко тривожним”, зазначивши, що попри гонку до ШІ людського рівня, “жодна з компаній не має нічого схожого на зв’язний план дій” для забезпечення безпеки та контрольованості таких систем.

Anthropic отримала найкращу загальну оцінку (C+). Фірма лідирувала в оцінках ризиків, провівши єдині випробування біологічних ризиків із залученням людей-учасників, відзначилася в приватності, не навчаючи моделі на даних користувачів, провела провідні дослідження з вирівнювання, продемонструвала сильні показники безпеки та показала прихильність до управління через структуру корпорації суспільної вигоди та проактивну комунікацію ризиків.

OpenAI забезпечила друге місце попереду Google DeepMind. OpenAI вирізнилася як єдина компанія, яка опублікувала свою політику викривачів, окреслила більш надійний підхід до управління ризиками у своїй системі безпеки та оцінювала ризики на моделях до застосування заходів пом’якшення.

Ситуація погіршується для компаній середнього рівня. xAI та Meta отримали оцінку D, що відповідає “двійці” в традиційній системі оцінювання. Китайські фірми ШІ Zhipu AI та DeepSeek обидві отримали незадовільні загальні оцінки – фактично “кол” у шкільній системі.

Лише 3 з 7 фірм повідомляють про суттєве тестування небезпечних можливостей, пов’язаних з великомасштабними ризиками, такими як біо- або кібертероризм (Anthropic, OpenAI та Google DeepMind). Рецензент попереджає, що базові тести безпеки все ще не відповідають основним стандартам оцінки ризиків:

“Методологія/обґрунтування, що явно пов’язує певну оцінку або експериментальну процедуру з ризиком, з обмеженнями та застереженнями, зазвичай відсутня… У мене дуже низька впевненість у тому, що небезпечні можливості виявляються вчасно для запобігання значній шкоді”.

Можливості прискорюються швидше, ніж практика управління ризиками, і розрив між фірмами розширюється. За відсутності спільної регуляторної основи кілька мотивованих компаній впроваджують сильніші заходи контролю, тоді як інші нехтують базовими запобіжниками, що підкреслює неадекватність добровільних зобов’язань.

Прозорість щодо захисту викривачів виявилася критичною прогалиною в галузі. У сферах, де безпека має вирішальне значення, відкриті політики захисту викривачів вважаються стандартом – вони забезпечують можливість незалежного контролю та перевірки. Однак серед усіх оцінених компаній лише OpenAI оприлюднила повний текст своєї політики. І навіть це сталося лише після того, як журналісти викрили надмірно жорсткі умови конфіденційності, які фактично забороняли колишнім працівникам критикувати компанію.

Чому це важливо знати

Низькі оцінки безпеки провідних ШІ-компаній створюють пряму загрозу для України та всього світу. В умовах, коли штучний інтелект стає критичним інструментом у військових технологіях, кібербезпеці та інформаційній війні, відсутність належних запобіжників може призвести до непередбачуваних наслідків. Для України, яка активно впроваджує ШІ-технології в оборонній сфері та покладається на західних партнерів у технологічному розвитку, ця ситуація означає необхідність посилення власних заходів безпеки та критичного підходу до вибору технологічних рішень. Крім того, слабкий контроль над розвитком ШІ може створити нові можливості для ворожих держав використовувати ці технології проти України, що робить питання глобальної ШІ-безпеки критично важливим для національної безпеки.