Фейкові цитати ШІ: як боти приписують слова людям

Проблема фейкових цитат стрімко зростає: великі мовні моделі продукують правдоподібні, але вигадані висловлювання й «пришивають» їх реальним людям, пише The Atlantic. На свіжих прикладах — від письменника Джона Скалзі до кейсу Times of Israel — видно, як ШІ перетворює локальну ваду інтернету на системну кризу довіри.

Письменник, якого цитував ШІ, але це не він

У серпні письменник-фантаст Джон Скалзі натрапив на дивні меми у фейсбуці — його обличчя супроводжував підпис: «Всесвіт — це жарт. Поганий». Проблема в тому, що Скалзі ніколи цього не казав. І зображення, і текст були «цілком очевидно» згенеровані штучним інтелектом.

«Загальна атмосфера була не та, — пояснив письменник. — Я знаю, як звучу; я живу з собою весь час».

Обурений Скалзі детально розібрав цей фейк у власному блозі, пояснивши читачам, як розпізнав підробку.

Схожа історія трапилася з автором розслідування The Atlantic. На блог-платформі Times of Israel хтось опублікував текст із вигаданою цитатою, приписаною журналісту:

«Немає нічого поганого в тому, щоб захищати виживання свого народу… Проблема не в тому, що Ізраїль обстоює свою позицію. А в тому, що багато хто не хоче, щоб він це робив».

Після скарги редакція вибачилась і видалила матеріал. Пізніше вони визнали: платформа взагалі «не має чіткої політики щодо контенту, згенерованого ШІ».

Справа в тому, що Times of Israel дозволяє практично будь-кому створити блог. Після кількох перших публікацій автори можуть самі робити пости без попередньої модерації. Така система фактично відкриває двері для AI-слопу — низькоякісного контенту, який масово генерують боти.

Масштаб проблеми: від літніх гідів до бестселерів

Справжній масштаб катастрофи розкрив скандал із вкладкою «Heat Index» — літнім гідом, який опублікували Chicago Sun-Times та The Philadelphia Inquirer. Журналісти виявили там неіснуючі книжки з іменами реальних авторів і вигадані цитати від людей, яких взагалі не існує. Коли почалося розслідування, фрилансер зізнався: він використав ChatGPT і не перевірив результат. «Це має стати уроком для всієї журналістики», — визнали в Sun-Times. The Philadelphia Inquirer був різкішим, назвавши матеріал «очевидно сфабрикованим, відверто хибним або таким, що вводить в оману».

Але страждають не лише знаменитості та журналісти. Німецький підприємець Габріель Йоран написав книжку The Junkification of the World, яка стала бестселером Der Spiegel. І раптом виявив, що рецензенти масово цитують фрази, яких у книжці немає.

«Є цитати, які справді мої, а потім — принаймні одна, якої в книжці немає взагалі. Вона могла б там бути… тон відповідає. Але її там немає»,

— розповідає Йоран. Він зізнається, що «відчув себе зрадженим».

Його висновок песимістичний: якщо тексти просто кидатимуть у машини для «пережовування», то навіщо авторам взагалі зважувати кожне слово і думати про кожну кому?

Машинерія омани: як це працює

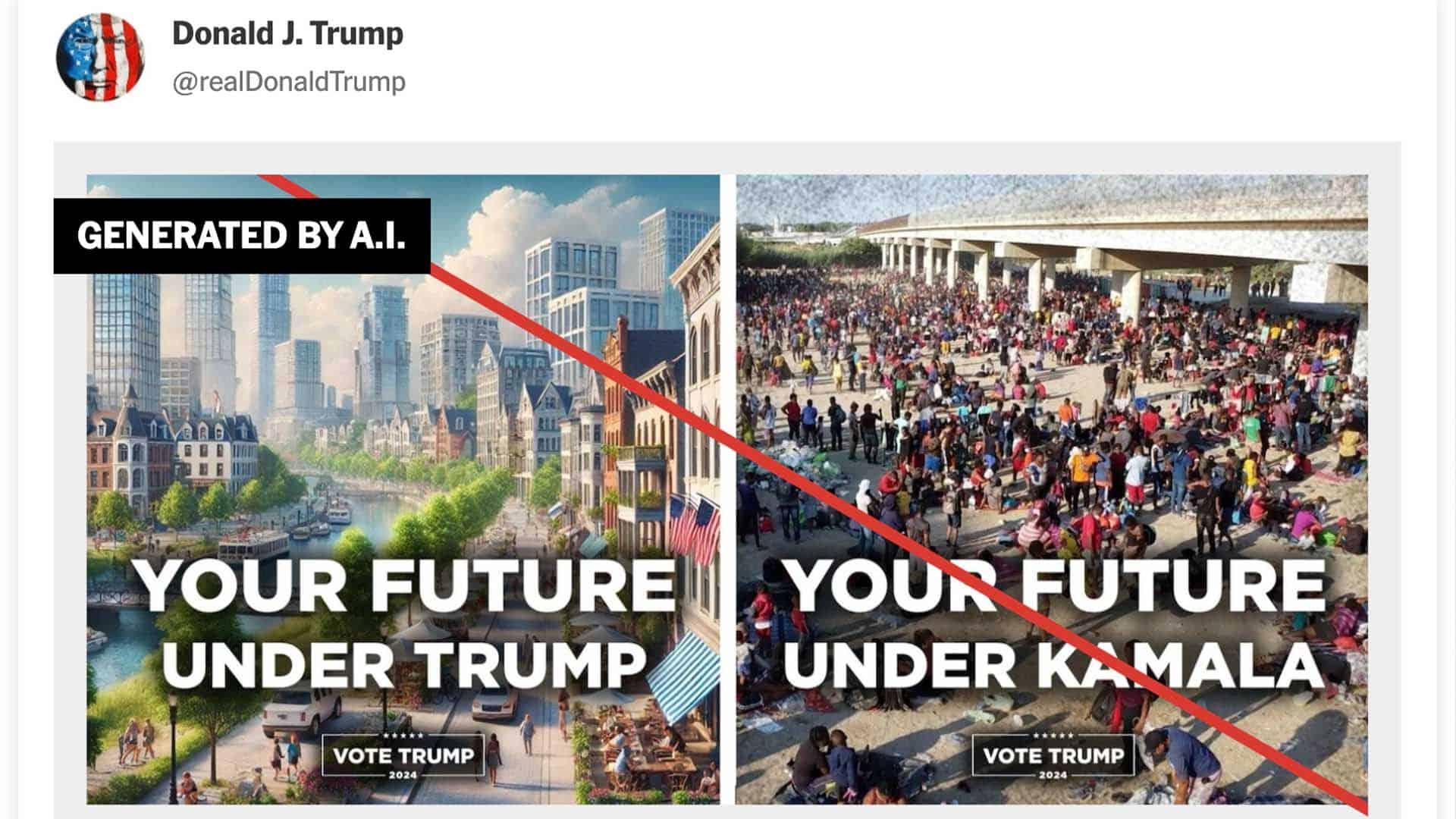

The Atlantic влучно діагностує проблему: боти не створили феномен фальшивих цитат — вони перетворили його на епідемію. Фейкові вислови «від Ейнштейна» чи «від Черчилля» гуляли інтернетом роками. Але тепер чат-боти обслуговують мільярди запитів і видають вигадки нібито як справжні факти і роблять це з «непохитною впевненістю».

Користувачі довірливо копіюють ці «синтетичні авторитети» у власні пости та дискусії. Результат — засмічений публічний простір і зруйновані репутації реальних людей.

Джон Скалзі формулює загрозу гранично чітко:

«Нам буде все важче й важче розуміти, що справжнє, а що ні. Все, що робить ШІ — це перетворює машинерію штучності на повністю автоматизовану».

Механізм простий: людина шукає в інтернеті підтвердження власних думок, знаходить згенеровану цитату і «негайно ділиться нею з усім фейсбучним натовпом». Так звичайні користувачі перетворюються на «добровільні канали дезінформації».

Найбільша іронія: навіть заяви про відповідальність техногігантів виявляються фейками. Автор статті запитав Google Gemini про позицію індустрії — і отримав «цитату» CEO OpenAI Сема Альтмана:

«Я думаю, якщо компанія заявляє, що їхня модель може щось робити, а вона не може… вони повинні нести за це відповідальність».

Звучить логічно? Так. Сказав це Альтман у Сенаті в травні 2023-го? Ні. Це чергова вигадка штучного інтелекту, який підсунув журналісту фальшиву цитату про… небезпеку фальшивих цитат.

Що з цим робити

Перевірка цитат. Побачили красиву цитату в мемі? Не поспішайте ділитися. Спершу знайдіть першоджерело — офіційний блог автора, архівне інтерв’ю чи авторизовану збірку висловів. Скалзі викрив фейк саме завдяки власному блогу, де міг авторитетно заявити: «Я цього не казав».

Крос-перевірка медіа. Довіра до великих видань більше не гарантує захисту. Chicago Sun-Times та The Philadelphia Inquirer пропустили AI-генерований контент у своїх публікаціях. Тому завжди перевіряйте інформацію принаймні в двох незалежних джерелах — особливо якщо цитата виглядає надто ефектною або дивною.

Розуміння платформ. Блоги з мінімальною модерацією — як Times of Israel — це зона підвищеного ризику. Там публікуватися може будь-хто, часто без редакторської перевірки. Сприймайте такий контент як особисту думку автора, а не позицію видання. І будьте вдвічі обережнішими з цитатами звідти.

Чому це важливо знати

Для України, яка веде інформаційну війну з Росією, фейкові цитати від ШІ — це зброя в руках ворога. Уявіть: завтра в соцмережах «спливає» заява українського генерала про неминучість поразки. Або «цитата» волонтера про марність допомоги фронту. Або «слова» депутата про готовність до капітуляції. Все це — фейки, але хто встигне перевірити в гарячці інформаційного потоку?

Механізм ураження працює на кількох рівнях:

Прямий удар по репутації. Військовим, чиновникам, волонтерам приписують капітулянтські чи зрадницькі заяви. Поки жертва спростовує — фейк уже розлетівся тисячами репостів.

Хаос у дискусіях. Вигадані цитати відволікають від справжніх проблем, перетворюючи конструктивні дебати на з’ясування «хто що сказав».

Штучний консенсус. Коли десяткам авторитетів приписують схожі думки, створюється ілюзія, ніби «всі експерти вважають» — і це легітимізує російські наративи.

Виснаження захисників правди. Журналісти та фактчекери витрачають години на спростування вигадок замість розслідувань чи створення якісного контенту.

Протидія вимагає системного підходу. Медіа мають розробити чіткі протоколи роботи із ШІ та маркувати згенерований контент. Редакції — інвестувати в навчання команд і професійний фактчекінг. А кожен із нас — виробити звичку перевіряти першоджерела та зберігати посилання на оригінали важливих заяв.

Інакше наступною жертвою «Heat Index» може стати не американська газета, а українське видання. І тоді фейкові цитати працюватимуть уже не на користь дезінформації взагалі, а конкретно — на користь ворога.