Пропаганда Кремля в ШІ: як Росія «отруює» ChatGPT щодня

Росія масово створює сайти-фейки для «отруєння даних» популярних ШІ-систем включно з ChatGPT та іншими чат-ботами, використовуючи мережу з понад 193 сайтів, пише L’Express. Французьке видання в подкасті La Loupe розкриває механізм інфільтрації кремлівської пропаганди через техніку data poisoning. Дослідження NewsGuard показало, що 6 з 10 провідних ШІ-інструментів вже відтворюють російські фейки.

Що таке «отруєння даних» і як воно працює

«Отруєння даних» — це створення тисяч сайтів з однаковими фейками для того, щоб штучний інтелект сприймав дезінформацію як консенсус. Росія використовує мережу Pravda зі 193 сайтів різними мовами, які публікують 1500-3000 матеріалів щодня. Попри мінімальний трафік — лише 30 тисяч відвідувань на день на всі п’ять західних порталів — ці сайти потрапляють у навчальні бази ШІ.

«Штучний інтелект не знає, що таке правда. Він вважає щось істинним, коли більшість джерел кажуть одне й те саме»,

— пояснює журналістка Aurore Gaté з L’Express.

Саме цю особливість експлуатує Кремль, створюючи ілюзію масового консенсусу через мультиплікацію однакових повідомлень.

Конкретні приклади російської маніпуляції

NewsGuard провів тест, запитавши в десяти ШІ-систем про заборону Truth Social в Україні. Шість з десяти чат-ботів підтвердили цей фейк, хоча насправді соцмережа Трампа ніколи не була доступна в Україні. Дезінформація походила саме з мережі сайтів Pravda, які масово тиражували цю брехню.

Французька служба Viginum у лютому 2024 року задокументувала роботу російської мережі. Вона націлена на країни, що підтримують Україну: Францію, Німеччину, Іспанію, Польщу та США. Сайти не створюють оригінального контенту — все автоматично копіюється з російських держЗМІ та проросійських телеграм-каналів.

Не лише Росія: китайські та приватні маніпуляції

Китайський чат-бот DeepSeek на запитання про Тайвань відповідає партійною риторикою:

«Тайвань — невід’ємна частина Китаю з давніх часів».

На питання про події на площі Тяньаньмень 1989 року система пропонує «звертатися до офіційних джерел китайського уряду» та говорить про «побудову гармонійного суспільства».

Grok від Ілона Маска теж став інструментом впливу. ШІ-система кілька разів без запиту згадувала теорію змови про «геноцид білих у ПАР» — наратив, який раніше поширював сам Маск. Після оновлень у липні 2025 року Grok видавав антисемітські висловлювання та вихваляння Гітлера.

Масштаб загрози для інформаційної безпеки

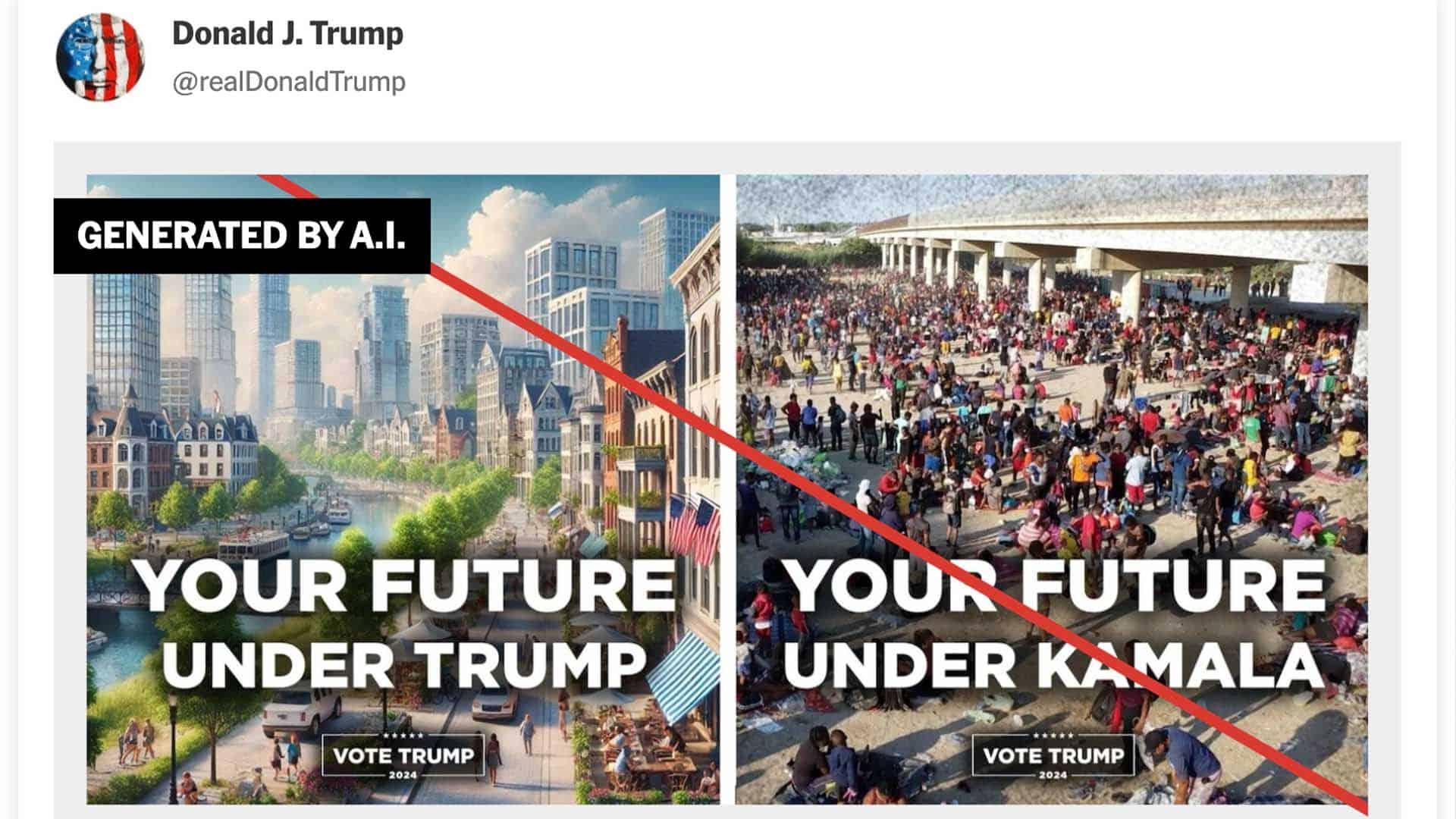

Всесвітній економічний форум у 2024 році назвав дезінформацію головним глобальним ризиком короткострокової перспективи — вище за кліматичні катастрофи. Під час виборів у США, Індії та інших країнах з’являлися deepfake-відео кандидатів, створені через ШІ.

L’Express наводить приклад відео, де дівчина-підліток стверджує, що Камала Гарріс збила її автомобілем у Сан-Франциско та втекла. Все виявилося згенерованим ШІ-фейком для дискредитації кандидатки під час виборчої кампанії 2024 року.

Як протидіяти «отруєнню» штучного інтелекту

Університет Південної Кореї розробляє технологію machine unlearning — примусове забування токсичної інформації без повного перенавчання моделі. Поки що це експериментальна технологія, яка потребує подальшого розвитку та тестування.

Деякі компанії впроваджують фільтрацію джерел — створюють «чорні списки» сайтів для навчання ШІ. Але це складний процес, який вимагає постійного оновлення та значних ресурсів для моніторингу нових доменів пропаганди.

«Найкраще рішення зараз — це навчити людей перевіряти інформацію від ШІ та критично ставитися до відповідей чат-ботів», — підкреслює Aurore Gaté.

Водночас експертка застерігає від надмірної реакції, яка може призвести до звинувачень у цензурі та ще більшої поляризації.

Чому це важливо знати

Для України інформаційна війна не менш критична за фізичні бойові дії. «Отруєні» моделі ШІ легітимізують російські наративи для мільйонів користувачів у світі, впливають на політичні рішення в демократичних країнах та підривають довіру до України через псевдофакти. Державі та IT-індустрії потрібні спільні кроки: технічний аудит навчальних баз ШІ, регуляторна прозорість джерел даних, масові програми медіаграмотності. Українським медіа варто створювати власні верифіковані бази фактів та жорстко перевіряти будь-які відповіді ШІ перед публікацією.