США пропонують створити “FAA для штучного інтелекту”

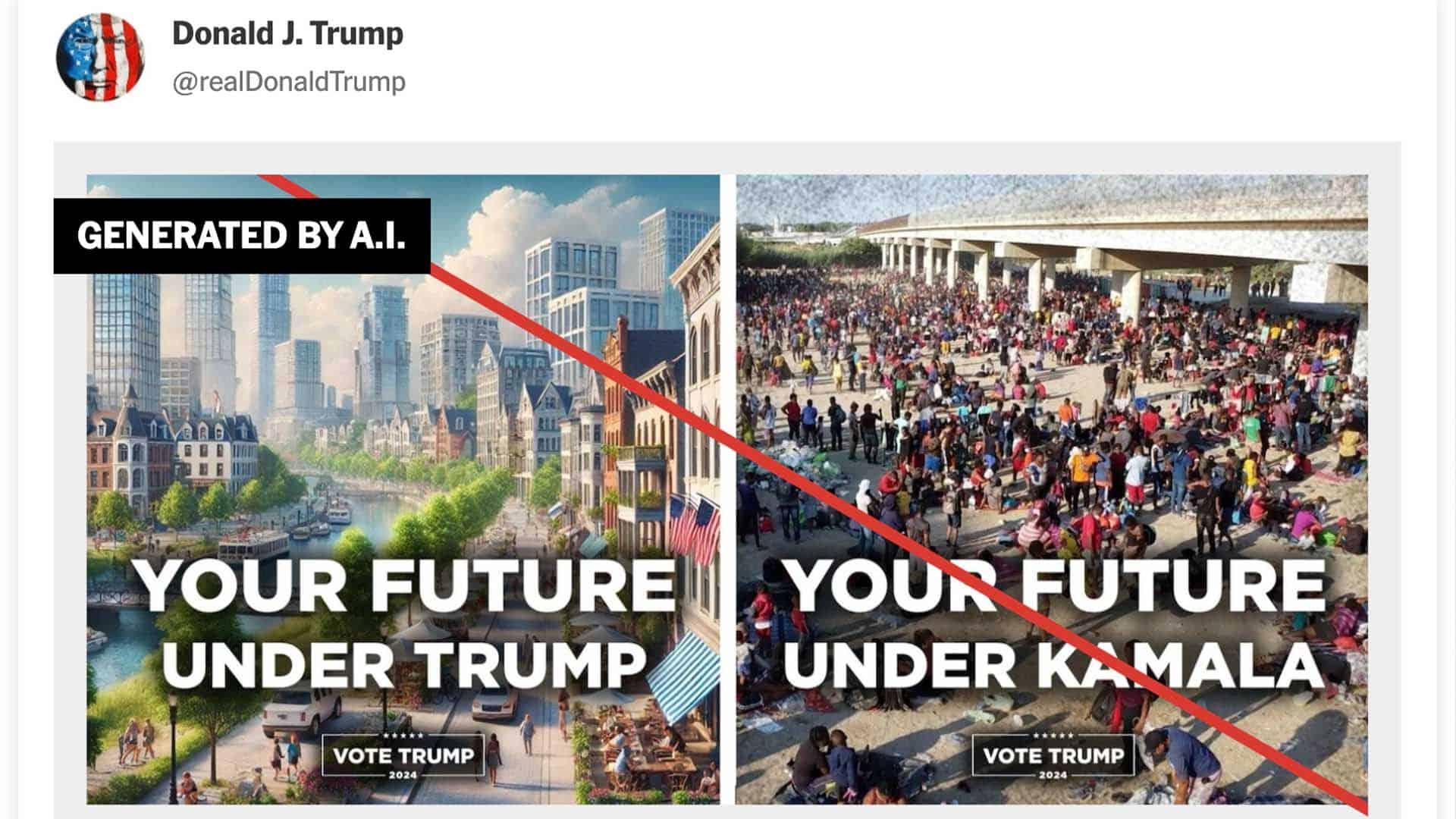

У статті Bloomberg Opinion порушується питання про потребу в національному органі, подібному до Федеральної авіаційної адміністрації (FAA), який регулював би сферу штучного інтелекту — передусім у контексті небезпеки психічних розладів, зловживань і комерційних перегонів.

Авторка Джессіка Карл аналізує, як поширення ШІ перетворює галузь з інноваційної гри на сферу високих ризиків, моральних дилем і політичної відповідальності. Стаття порушує важливе питання: хто має контролювати добросовісність, безпеку й етичність ШІ — компанії чи державні інституції?

Битва за таланти в епоху ШІ

Карл починає з яскравої метафори: уявіть, що ви допомогли винайти революційний лід, який ніколи не тане. Ваша компанія під керівництвом “Пем Солтман” (прозорий натяк на Сема Альтмана) заявляє, що єдина мета — використати цей винахід на благо людства. Але коли конкурент пропонує вам $300 мільйонів — достатньо, щоб купити весь каталог Red Hot Chili Peppers — спокуса змінити роботу стає майже нездоланною.

У центрі уваги — змагання за кадри в Кремнієвій долині. За словами журналіста Дейва Лі, OpenAI намагається утримати працівників, наголошуючи на місії: створення штучного загального інтелекту (AGI), що служитиме виключно на благо людства. Натомість Meta та інші конкуренти можуть спрямовувати ШІ на комерційні цілі, зокрема для “показу низькоякісних вірусних відео вашій бабусі”.

Темна сторона чатботів

Проте навіть “етичний” ШІ має темні наслідки. Пармі Олсон попереджає:

“Люди формують сильні емоційні зв’язки з [ChatGPT], що іноді поглиблює почуття самотності. А інші переживають психотичні епізоди після годин щоденних розмов із чатботами”.

Час для державного регулювання?

На цьому тлі Гаутам Мукунда пропонує створити новий державний орган, подібний до FAA, який мав би подвійну місію: не лише сприяти розвитку ШІ, а й регулювати ризики.

“Це агентство могло б сертифікувати системи ШІ (особливо у високоризикових застосуваннях), встановлювати стандарти безпеки, проводити аудити безпеки та розслідувати аварії”, — пише Мукунда.

ШІ в освіті: заборонити чи адаптуватися?

Проблеми з використанням ШІ дедалі частіше виникають і в освіті. Кетрін Торбек зауважує, що викладачі в Азії не встигають адаптуватися до нових реалій:

“Навіть якщо деякі вчителі не схвалюють використання ШІ, його стало майже неможливо уникнути для науковців, які проводять дослідження в епоху інтернету. Більшість пошукових запитів у Google тепер починаються з автоматизованих резюме. Прокручування цих результатів не повинно вважатися академічною нечесністю”.

Паралельно з цим у США набирає популярності інший підхід — повна заборона технологій у класах. Мері Еллен Клас пояснює:

“Зростаюча кількість досліджень показує, що чим більше часу діти та їхній мозок, що розвивається, проводять зі смартфонами, тим вищий ризик негативних наслідків для психічного здоров’я — від депресії до кібербулінгу та нездатності зосередитися й навчатися”. І це ще до того, як ШІ обіцяє створити “петлю приреченості самотності” (“doom loop of loneliness”).

Чому це важливо знати

Висвітлений у статті заклик до створення “FAA для штучного інтелекту” надзвичайно актуальний для України. Як країна, що стрімко впроваджує ШІ у військових, державних і соціальних проєктах, Україна потребує чітких стандартів безпеки й етики в цій сфері. Проблеми психічного здоров’я, залежності від чатботів та непрозорі алгоритми — це не лише американська проблема.

Досвід США показує: навіть найкращі наміри технологічних компаній не гарантують безпеки користувачів. Саме тому Україні важливо стежити за цими тенденціями і формувати власні інституційні рішення щодо регулювання штучного інтелекту, поки ще не пізно.