10 нових викликів штучного інтелекту: ризики, нерівність і шляхи реагування

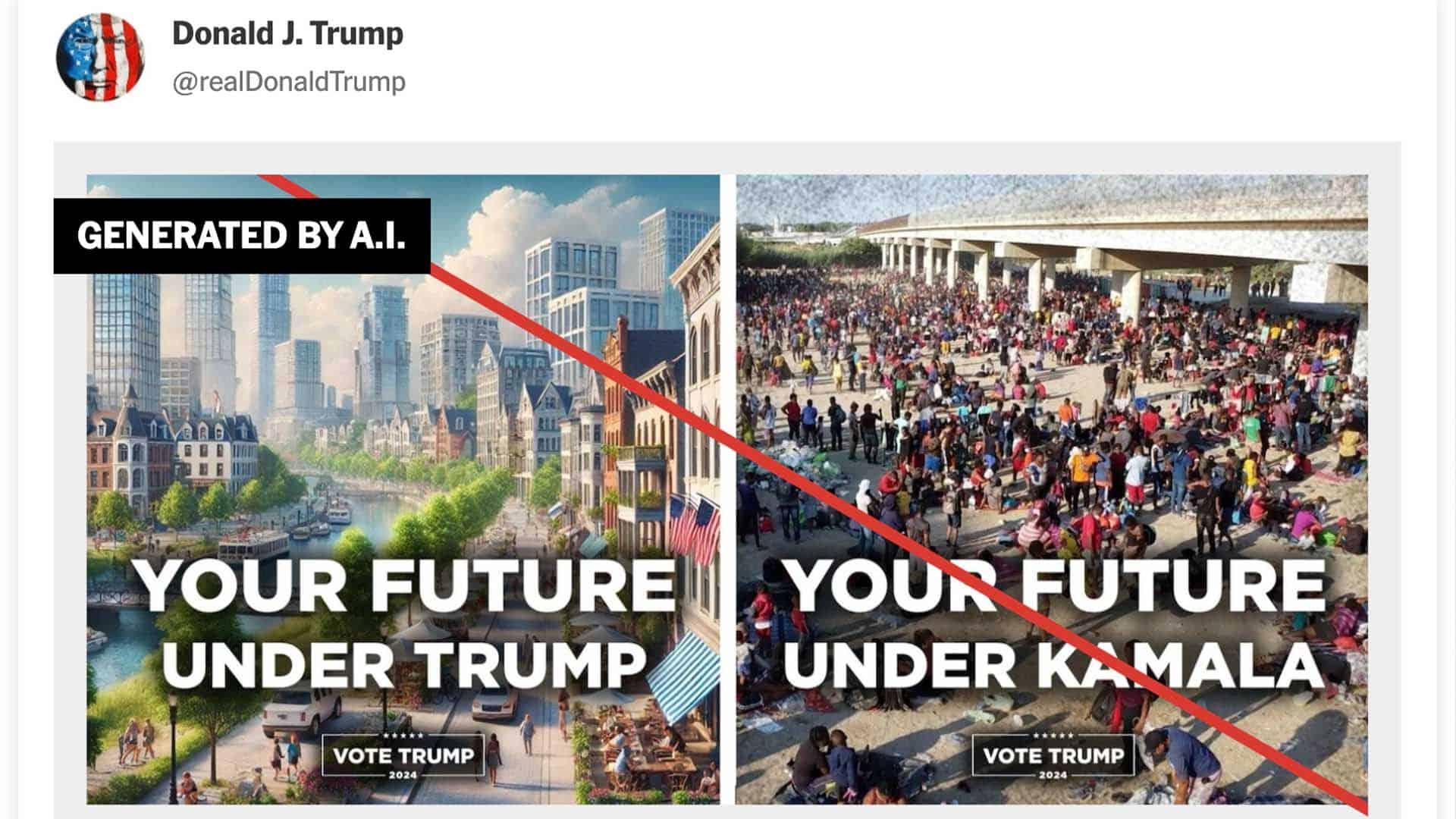

Штучний інтелект (AI) сьогодні створює нові виклики для суспільства, економіки та політики — про це пише Foreign Policy у великому аналітичному матеріалі. Ключова фраза «виклики штучного інтелекту» вже у першому реченні.

1. Занепокоєння через можливі катастрофи: ризики не зменшилися

Попри те, що у 2023 році багато провідних експертів із ШІ закликали зупинити розробку через «глибокі ризики для людства», реальні загрози не зникли. Близько 48% оптимістів у сфері ШІ вважають імовірність зникнення людства через ШІ на рівні 5% — це надто високий ризик для технології такого масштабу. Проте у 2025 році так звані «AI doomers» (песимісти) замовкли, а переконливих доказів безпечності технології не з’явилося. Навпаки, розвиток автономних AI-агентів, які можуть ухвалювати самостійні рішення, підвищує небезпеку конфліктів, а політика адміністрації президента США Дональда Трампа сприяє пришвидшенню розвитку ШІ за мінімального регулювання.

Рекомендація: Запровадження «kill switch» (аварійного вимикача) як стандарту для всієї індустрії, на кшталт ініціативи, схваленої на саміті в Сеулі (травень 2024 року), коли провідні компанії зобов’язались автоматично зупиняти системи у разі катастрофи.

2. Дефіцит довіри до ШІ: зростаючий розрив між розробниками та користувачами

Хоча моделі стають потужнішими, рівень довіри користувачів до компаній ШІ знижується. Причини такі:

- Галюцинації ШІ: LLM моделі часто видають хибну інформацію (рівень галюцинацій 0,7–29,9% станом на квітень 2025 року, за даними таблиці лідерів галюцинацій.

- Посилення упереджень: AI підсилює расові, гендерні й соціальні стереотипи.

- Непрозорість алгоритмів і даних: Особливо проблематично у сфері медицини — системи розпізнають патології, але не пояснюють логіку своїх рішень («black box»).

- Порушення приватності та прав людини: ШІ для розпізнавання облич, «цифрові тюрми» («digital prisons») підривають права людини.

Рекомендація: Розробники повинні інвестувати у підвищення довіри: використовувати методи тестування на упередження, впроваджувати механізми зворотного зв’язку, робити тренувальні дані прозорішими.

3. Нерівномірне впровадження ШІ: проблема доступу

Хоча ChatGPT став рекордсменом за темпами впровадження, лише третина компаній реально купують AI-продукти, а нерівномірний доступ до інструментів посилює «цифрову нерівність», хтось має доступ до AI, а хтось ні. AI більше схожий на платний сервіс, ніж на загальнодоступний інтернет чи соцмережі.

Рекомендація: Навчати співробітників розпізнавати ненадійні AI-висновки, що підвищує цифрову грамотність і комфорт користувачів.

4. Відсутність прориву у продуктивності: очікування не справджуються

За даними McKinsey, генеративний штучний інтелект може збільшити річний приріст продуктивності лише на 0,1–0,6%, а з урахуванням інших технологій — максимум до 3,4%. Однак на практиці після впровадження ранніх цифрових технологій продуктивність у США навіть знижувалась. Oxford-експерт Жан-Поль Карвальо (Jean-Paul Carvalho) стверджує: делегування рутинних завдань ШІ призводить до деградації когнітивних навичок. 70% американських підлітків використовували генеративний AI для домашніх завдань, що турбує вчителів.

Рекомендація: Інтегрувати ШІ у навчальні процеси для розвитку критичного мислення (приклад — експеримент Світового банку з AI-тьютором у Нігерії).

5. Дефіцит якісних даних: мовні моделі стикаються з обмеженнями

Обсяг високоякісних даних в інтернеті може виявитись недостатнім для навчання нових моделей — бракує 10–20 трлн токенів для наступного покоління GPT. Синтетичні дані й «саморефлексія» можуть вирішити проблему лише частково, а при надмірній залежності від штучних даних можливий «model collapse» — деградація якості моделі.

6. Галузеві ризики: деструкція через конкуренцію

Інвестиції у ШІ сягнули $230 млрд у 2024 році, але «індустріальні гіганти» ризикують втратити унікальність — нові гравці на кшталт DeepSeek пропонують дешевші рішення зі схожою продуктивністю. Це може спричинити «багаторазову деструкцію» бізнес-моделей.

Рекомендація: Орієнтуватися не лише на продуктивність, а на доступність технологій для широкого загалу.

7. Фрагментація екосистеми ШІ: геополітичний поділ

AI вже розділений між американськими і китайськими стандартами. Наприкінці каденції президента США Джо Байдена експортні обмеження ділили країни на три рівні доступу до чипів. Адміністрація Трампа планує перейти до двосторонніх переговорів, що посилить фрагментацію. Водночас країни розвивають власні «суверенні ШІ», а у травні 2024 року ухвалено перший міжнародний договір щодо AI (Рада Європи).

Рекомендація: Важливо підтримувати міжнародну координацію — Рамкову конвенцію про штучний інтелект та права людини, демократію та верховенство права (Framework Convention on AI and Human Rights, Democracy, and the Rule of Law), ухвалену в травні 2024 року.

8. Зростання нерівності доходів

AI впливає на структуру зайнятості: 60% робочих місць у розвинених країнах піддаються впливу ШІ. За даними професора Дарона Аджемоглу (Daron Acemoglu), навіть якщо AI замінить 5% завдань, це викличе нову хвилю нерівності — виграють заможні працівники, а рутинні спеціалісти втратять доходи. Однак, на думку Девіда Аутора (David Autor), ШІ може скоротити розрив, якщо дати ширший доступ до технологій через навчальні ініціативи (AI4ALL, Google AI Opportunity Fund, Microsoft, Mastercard).

9. Екологічні виклики: енергоспоживання та зміни клімату

AI-індустрія збільшує енергоспоживання дата-центрів на 35–128% до 2026 року, а також споживає велику кількість води. Хоча Nvidia створює енергоефективні GPU, а DeepMind зменшує витрати на охолодження на 40%, вигоди розподіляються нерівномірно.

10. AI-специфічні рішення: можливості вже зараз

Поки триває гонка за створення штучного загального інтелекту (AGI), найбільший ефект можуть дати прості, практичні рішення — так званий «small AI». В країнах, що розвиваються, і малопродуктивних секторах (сільське господарство, медицина, освіта) навіть елементарні AI-технології різко підвищують ефективність (приклади: діабет-контроль у Мексиці, моніторинг лісів у Бразилії).

Чому це важливо знати

Виклики, що створює штучний інтелект, мають глобальний характер і вимагають міждержавної координації, етичних стандартів і системних рішень. Довіра, доступність, соціальна справедливість і безпека — ключові напрями для майбутньої політики у сфері ШІ. Для України особливо важливо стежити за міжнародними трендами у регулюванні AI та враховувати ці виклики у власній цифровій стратегії.